INFORMATIQUE Histoire

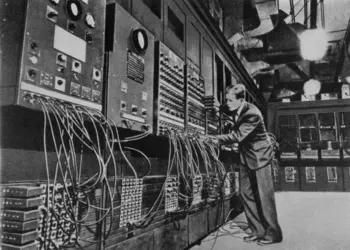

Un usage bien établi associe le mot « informatique » à l'ensemble des opérations de traitement de l'information effectuées à l'aide de machines électroniques perfectionnées conçues par essence pour aider l'être humain à surmonter au mieux l'opposition classique qui sépare dans ses activités la compétence de la performance. Les premières machines ont eu effectivement pour mission de pallier les insuffisances humaines en matière de performance de calcul : il s'agissait, par exemple, de résoudre des équations différentielles complexes pour la météorologie, de calculer les paramètres permettant la fabrication de la première bombe atomique, de procéder au recensement des citoyens américains en manipulant d'énormes quantités de données en un temps relativement bref. Ce qu'on savait imaginer naturellement (compétence) mais pas vraiment réaliser (performance). Ces machines, qui n'étaient alors que des calculatrices électromécaniques puis électroniques (computers), ont été ensuite détournées de leur but initial et sollicitées pour accroître la performance du couple homme-machine dans le domaine plus vaste des données non numériques. Dès le début des années 1950, le traitement de l'information acquiert droit de cité. Et le calculateur devient data processing machine, littéralement « machine à traiter les données » (qu'on baptisera bientôt « ordinateur » en France), sans aucune restriction sur la nature des données manipulées.

L'informatique à la conquête de l'entreprise

À peine sorti des laboratoires de recherche, et immédiatement installé dans les grandes universités, pour la plupart américaines et britanniques (la technologie informatique se développera à ses débuts sans la France), le calculateur électronique est vite dirigé vers les grandes administrations. Cela signifie que, très tôt (dès 1951, avec l'Univac), son champ d'application se dédouble, faisant apparaître deux grandes classes d'activités : scientifiques, d'une part, administratives et commerciales, d'autre part. Les machines sont alors énormes, elles consomment une énergie phénoménale et occupent une salle spécialement aménagée (l'air conditionné étant un élément d'environnement indispensable). Dès 1954, elles commencent à investir les grandes entreprises publiques et privées.

Dans les premiers temps, à cause de la prédominance du « matériel » (hardware), héritée de la mécanographie, et en raison du fait que le système binaire et ses dérivés sont les seuls systèmes de codification externe mis en œuvre, les relations entre l'homme et la machine sont complexes et nécessitent le recours à des spécialistes. La structure de l'entreprise en est aussitôt modifiée ; un pôle puissant apparaît, le département informatique, qui prendra de jour en jour une importance considérable et constituera très vite un nouveau centre de pouvoir. La nécessaire centralisation des ressources (puissance de calcul et capacités de stockage) et la concentration des informations clés relatives au fonctionnement et à la stratégie de l'entreprise confèrent aux cadres responsables de la mise en place de cette technologie de pointe un rôle prédominant.

En même temps, de nouvelles professions spécialisées apparaissent. Elles correspondent aux différentes étapes du processus de traitement des données, selon le cheminement utilisateur final, données d'entrée, machine, résultats, utilisateur final. Ces techniciens sont des intermédiaires obligés pour cause d'incompatibilité de langage entre l'homme et la machine. On trouve ainsi, dans la chaîne des travaux :

– l'analyste, qui traduit les besoins de l'utilisateur final en un schéma logique (organigramme) décrivant la succession des opérations nécessaires pour aboutir à un résultat exploitable[...]

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Pierre GOUJON : mathématicien

Classification

Pour citer cet article

Pierre GOUJON. INFORMATIQUE - Histoire [en ligne]. In Encyclopædia Universalis. Disponible sur : (consulté le )

Média

Autres références

-

PHYSIQUE - Physique et informatique

- Écrit par Claude ROIESNEL

- 6 760 mots

La révolution informatique est de nature technologique. Les physiciens sont associés à toutes les étapes de son développement. Les technologies incorporées dans les premiers ordinateurs avaient été inventées pour les besoins de la recherche en physique nucléaire. Le convertisseur analogue-digital,...

-

AFFICHE

- Écrit par Michel WLASSIKOFF

- 6 817 mots

- 12 médias

Dansles années 1990, l'affiche est de plus en plus souvent conçue sur écran, la publication assistée par ordinateur (P.A.O.) permettant l'association des textes et des images. La mise au point du langage Postscript conduit à la création de caractères haute résolution et le dessin de lettres connaît... -

AIKEN HOWARD HATHAWAY (1900-1973)

- Écrit par Bernard PIRE

- 506 mots

L’Américain Howard Aiken fut un des pionniers de l'informatique, concepteur de l'IBM Automatic Sequence Controlled Calculator (ASCC) encore appelé Harvard Mark I.

Après avoir suivi les cours d'une école technique tout en travaillant la nuit, Howard Hathaway Aiken, né le 9 mars 1900 à...

-

APPLE

- Écrit par Pierre MOUNIER-KUHN

- 2 547 mots

- 2 médias

Archétype des start-up de la Silicon Valley, la société américaine Apple, fondée en 1976, a gagné fortune et célébrité par ses innovations de rupture, de l’ordinateur Macintosh au téléphone portable iPhone et à la tablette numérique iPad. Associée au talent visionnaire de son président historique,...

-

ARCHÉOLOGIE (Traitement et interprétation) - La photogrammétrie architecturale

- Écrit par Jean-Paul SAINT AUBIN

- 5 219 mots

- 1 média

...depuis les premières décades du xxe siècle, par les appareils de restitution, lourdes et fragiles machines optico-mécaniques. À la fin du xxe siècle, l'informatique et l'image numérique ont bouleversé la photogrammétrie, sinon dans ses principes, du moins dans ses méthodes qu'elles ont considérablement... - Afficher les 145 références

Voir aussi

- CALCULATEURS

- MICRO-ORDINATEUR

- RÉSEAUX LOCAUX, informatique

- SERVEUR, informatique

- NUMÉRIQUES CALCULATEURS

- IBM (International Business Machines Corporation)

- PÉRIPHÉRIQUES, informatique

- INFORMATION, informatique et télécommunications

- NTIC (nouvelles technologies de l'information et de la communication)

- MINI-ORDINATEUR

- MATÉRIEL, informatique

- CLIENT-SERVEUR, informatique

- PC (personal computer)

- TECHNIQUES HISTOIRE DES, XXe et début du XXIe s.

- TERMINAL, informatique et télécommunications

- ARCHITECTURE, informatique

- UNITÉ CENTRALE