OPTIMISATION & CONTRÔLE

Les problèmes concrets

On ne parlera ici ni des problèmes en dimension finie (cf. programmation mathématique) ni des méthodes numériques (cf. analyse numérique).

Équations aux dérivées partielles

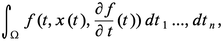

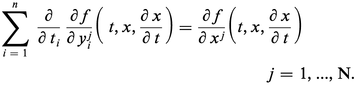

Soit Ω un ouvert borné de Rn. Si l'on cherche, dans un espace fonctionnel approprié, les fonctions x : Ω → RN prenant des valeurs données sur le bord de Ω et minimisant l'intégrale :

Beaucoup d'équations issues de la physique sont de ce type (on dit alors qu'on a affaire à un problème variationnel). Il est cependant fréquent que les solutions physiques ne minimisent pas l'intégrale ci-dessus, mais correspondent à d'autres types de points critiques.

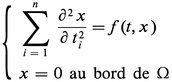

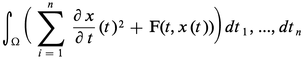

Il reste cependant des cas (problèmes elliptiques essentiellement) où l'on peut ramener la résolution d'une équation aux dérivées partielles à un problème d'optimisation. Le cas classique est le problème de Dirichlet (avec N = 1) :

Les moyens modernes, particulièrement la théorie des espaces de Sobolev, permettent d'étendre cette méthode à des situations plus compliquées. La nécessité de résoudre le problème d'optimisation correspondant, et donc d'employer le théorème d'existence cité plus haut, conduit à quelques traits généraux :

(a) les termes d'ordre supérieur (2 dans l'exemple cité) doivent constituer le sous-différentiel d'une fonction convexe : on dit qu'ils sont elliptiques. Les termes d'ordre inférieur sont moins déterminants, et peuvent en général être traités par des méthodes de compacité ;

(b) les espaces fonctionnels où l'on cherche la solution doivent être réflexifs, ce qui exclut l'usage de Cr. Il faudra travailler dans des espaces construits à partir des Lp, 1 < p < ∞, et la solution x̄ du problème d'optimisation ne sera pas nécessairement différentiable, et ne vérifiera l'équation désirée qu'en un sens à préciser (solution faible). La résolution complète de l'équation nécessitera donc une deuxième étape, où l'on montrera par des méthodes ad hoc que la solution faible x̄ trouvée est en fait suffisamment différentiable pour vérifier l'équation en chaque point (solution classique) : c'est le problème de la régularité, qui est ainsi séparé du problème de l'existence.

Le cas des systèmes (N > 1) est encore mal compris, et suscite beaucoup d'intérêt à l'heure actuelle, en liaison avec certains problèmes de mécanique des solides (élasticité non linéaire).

À côté des simples équations, les inéquations ont maintenant acquis droit de cité. Elles apparaissent naturellement quand on envisage ces problèmes sous l'angle de l'optimisation. Ainsi, la condition nécessaire et suffisante d'optimalité dans le cas convexe (cf. supra) s'écrira :

On dit que x̄ est une solution de l'inéquation variationnelle :

Cette notion est apparue comme essentielle pour la formulation correcte d'un grand nombre de problèmes de mécanique et de physique (frottement sec, problèmes avec obstacle). Ainsi, par exemple, le problème de Dirichlet avec un obstacle symbolisé par la fonction ϕ(t)

La suite de cet article est accessible aux abonnés

- Des contenus variés, complets et fiables

- Accessible sur tous les écrans

- Pas de publicité

Déjà abonné ? Se connecter

Écrit par

- Ivar EKELAND : professeur de mathématiques à l'université de Paris-IX-Dauphine (Centre de recherche de mathématiques de la décision). président honoraire à l'Université Paris-Dauphine

Classification

Pour citer cet article

Ivar EKELAND. OPTIMISATION & CONTRÔLE [en ligne]. In Encyclopædia Universalis. Disponible sur : (consulté le )

Article mis en ligne le et modifié le 14/03/2009

Médias

Autres références

-

AUTOMATISATION

- Écrit par Jean VAN DEN BROEK D'OBRENAN

- 11 882 mots

- 12 médias

Les algorithmes d'apprentissage sont généralement des algorithmes d'optimisation : ils cherchent à minimiser une fonction « de coût » qui mesure l'écart entre les réponses réelles et les réponses optimisées. L'optimisation se fait de manière itérative. Il existe des algorithmes d'optimisation non linéaire... -

CONVEXITÉ - Ensembles convexes

- Écrit par Victor KLEE

- 4 666 mots

- 7 médias

De nombreux problèmes de programmation linéaire et d'optimisation reviennent à trouver les points d'un polyèdre P où une fonction linéaire atteint son minimum ; on montre que, si P est borné, le minimum est alors atteint en un des sommets de P et certains procédés de résolution de programmes linéaires... -

FONCTIONS REPRÉSENTATION & APPROXIMATION DES

- Écrit par Jean-Louis OVAERT et Jean-Luc VERLEY

- 18 453 mots

- 6 médias

Avec les notations du chapitre précédent, nous allons étudier les deux problèmes suivants : -

NUMÉRIQUE ANALYSE

- Écrit par Jean-Louis OVAERT et Jean-Luc VERLEY

- 6 378 mots

On obtient une autre estimation, beaucoup plus fine que celle qui est donnée par le théorème 2, par la théorie de l'optimisation. En appliquant le théorème 4 du chapitre précédent, on obtiendra ce qui suit.